Deep convolutional and recurrent networks for image, speech, and text

- Imprimer

- Partager

- Partager sur Facebook

- Partager sur X

- Partager sur LinkedIn

Équipe action

Description scientifique

Les réseaux de neurones convolutifs profonds (CNN pour convolutional neural networks) et les réseaux de neurones récurrents (RNN pour recurrent neural networks) ont récemment permis des avancées majeures dans divers domaines, notamment la reconnaissance d'objets, la traduction automatique et la reconnaissance vocale. L'une des principales caractéristiques distinctives de ces approches, dans différents domaines d'application, est leur capacité d'apprentissage de bout en bout.

Les méthodes conventionnelles reposent généralement sur une étape de prétraitement du signal au cours de laquelle des caractéristiques sont extraites, comme le MFCC (Mel Frequency Cepstral Coefficients) pour la parole ou le SIFT (scale-invariant feature transform) pour les images. Dans les systèmes profonds et entraînables de bout en bout, chaque couche de traitement (du signal d'entrée brut vers le haut) implique des paramètres entraînables qui permettent au système d'apprendre les caractéristiques les plus appropriées. DeCoRe fédère des chercheurs du LJK, du GIPSA-LAB et du LIG en vision par ordinateur, apprentissage automatique, parole, traitement du langage naturel et recherche d'information, afin de favoriser la recherche collaborative dans ce domaine en pleine évolution, susceptible de soutenir les avancées futures dans ces domaines de recherche au cours de la prochaine décennie.

Deux doctorants sont entièrement financés par DeCoRe. L'un travaille sur la génération automatique de descriptions d'images en langage naturel. L'autre travaille sur les techniques de reconnaissance et de localisation d'objets dans des contextes impliquant de nombreuses classes d'objets (> 1 000) et des flux de données continus pour l'apprentissage.

Résultats

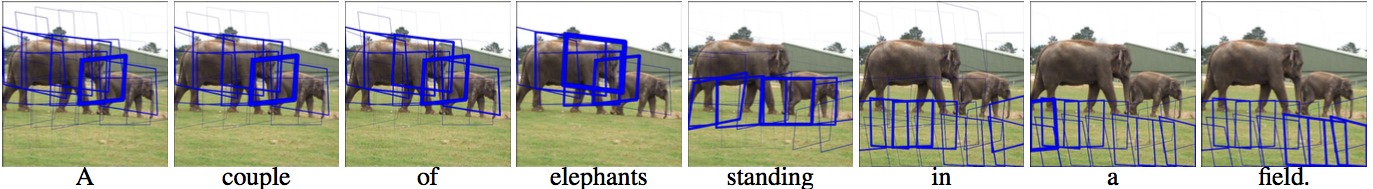

De grands progrès ont récemment été réalisés dans la génération automatique de légendes d'images en langage naturel grâce aux modèles encodeur-décodeur. Ces modèles encodent le contenu de l'image à l'aide d'un réseau de neurones convolutifs en une représentation vectorielle. Un décodeur de réseau de neurones récurrents utilise cette représentation vectorielle pour écrire séquentiellement une phrase en langage naturel conditionnée par le contenu de l'image. Nous avons développé un modèle basé sur ce paradigme encodeur-décodeur, qui prend en compte séquentiellement différentes régions de l'image au fur et à mesure de la production de la phrase (voir figure ci-dessous).

Cela nous permet de produire de meilleures légendes d'images, car les apparences visuelles locales peuvent être associées aux mots de la légende, au lieu de devoir transmettre toutes les informations visuelles via une seule représentation d'image globale. Ce travail a été soumis pour publication [3].

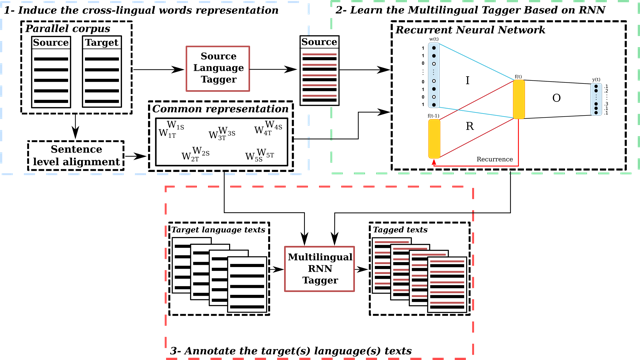

Dans un autre travail, nous avons proposé un réseau de neurones pour la projection multilingue d'annotations en traitement du langage naturel [5] (voir figure ci-dessous).

Coordinateurs

Laurent Besacier (LIG)

Denis Pellerin (GIPSA-lab)

Georges Quénot (LIG)

Jakob Verbeek (Inria/LJK)

Valorisation

Les travaux de recherche menés dans le cadre de DeCoRe ont déjà donné lieu à deux soumissions à l'appel CHIST-ERA 2017 sur les systèmes d'apprentissage tout au long de la vie :

- LLAMA : Approches d'apprentissage tout au long de la vie pour l'analyse multimédia.

- ADEL2 : Conduite autonome facilitée par l'apprentissage tout au long de la vie.

Publications significatives

[1] A. Berard, O. Pietquin, C. Servan, and L. Besacier. Listen and translate: A proof of concept for end-to-end

speech-to-text translation. In NIPS Workshop on end-to-end learning for speech and audio processing, 2016.

[2] P. Luc, C. Couprie, S. Chintala, and J. Verbeek. Semantic segmentation using adversarial networks.

In NIPS Workshop on Adversarial Training, 2016.

[3] M. Pedersoli, T. Lucas, C. Schmid, and J. Verbeek. Areas of attention for image captioning. arXiv:1612.01033.

[4] S. Saxena and J. Verbeek. Convolutional neural fabrics. In Advances in Neural Information Processing Systems (NIPS) 29, 2016.

[5] O. Zennaki, N. Semmar, and L. Besacier. Inducing multilingual text analysis tools using bidirectional recurrent neural networks. In COLING, 2016.

- Imprimer

- Partager

- Partager sur Facebook

- Partager sur X

- Partager sur LinkedIn